@@ -78,7 +78,7 @@ train

tree -r -i -f train | grep -E "jpg|JPG|jpeg|JPEG|png|PNG" | awk -F "/" '{print $0" "$2}' > train_list.txt

```

-其中,如果需要传入更多的数据类型,可以增加 `grep -E`后的内容, `$2`中的`2`为类别号文件夹的层级。

+其中,如果涉及更多的图片名称尾缀,可以增加 `grep -E`后的内容, `$2` 中的 `2` 为类别号文件夹的层级。

**备注:** 以上为数据集获取和生成的方法介绍,这里您可以直接下载有人/无人场景数据快速开始体验。

@@ -105,20 +105,20 @@ cd ../

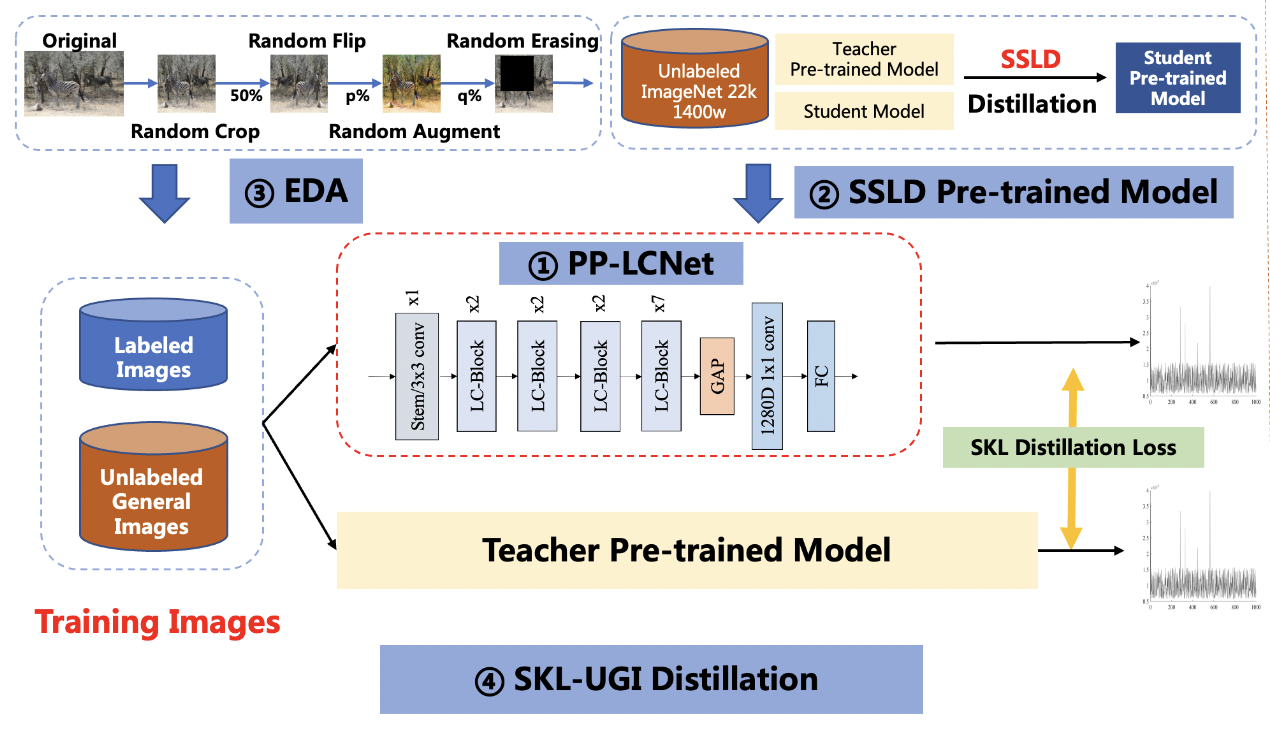

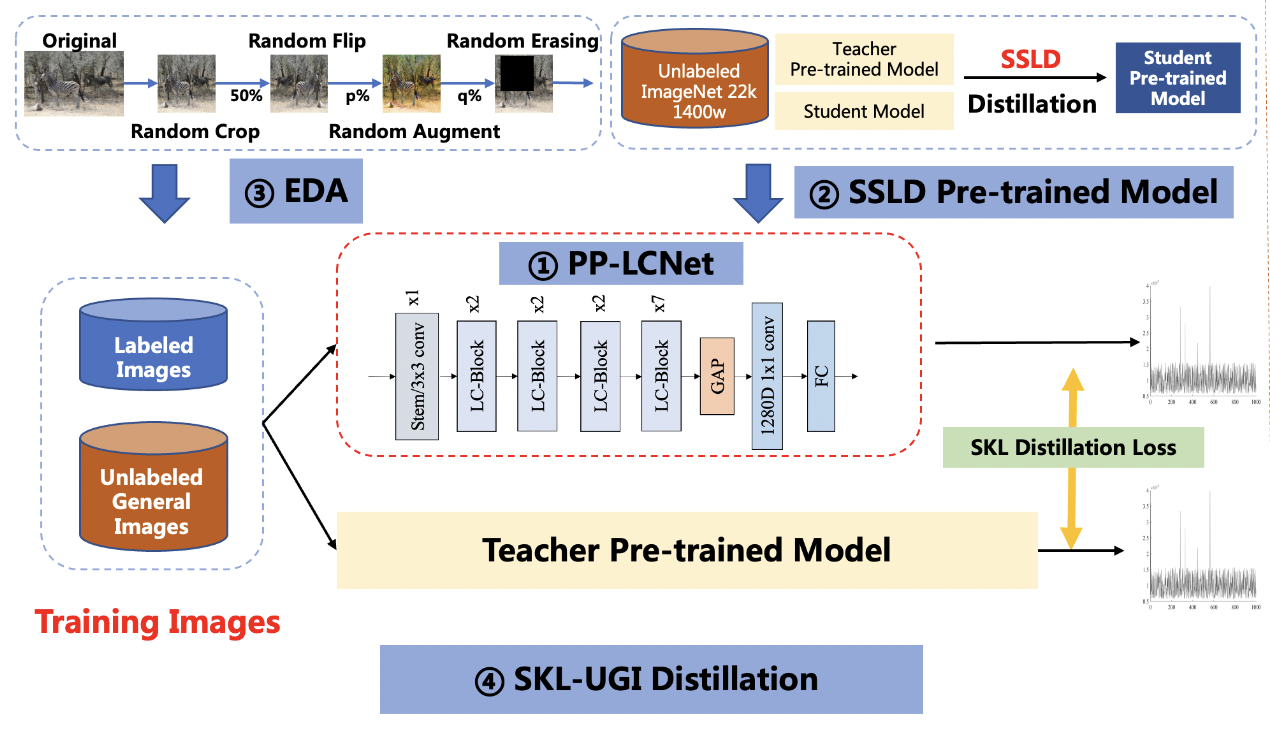

#### 3.1 骨干网络PP-LCNet

-PULC采用了轻量骨干网络PP-LCNet,相比同精度竞品速度快50%,您可以在[PP-LCNet介绍](../models/PP-LCNet.md)查阅该骨干网络的详细介绍。

-直接使用PP-LCNet训练的命令为:

+PULC 采用了轻量骨干网络 PP-LCNet,相比同精度竞品速度快 50%,您可以在[PP-LCNet介绍](../models/PP-LCNet.md)查阅该骨干网络的详细介绍。

+直接使用 PP-LCNet 训练的命令为:

```shell

export CUDA_VISIBLE_DEVICES=0,1,2,3

python3 -m paddle.distributed.launch \

--gpus="0,1,2,3" \

tools/train.py \

- -c ./ppcls/configs/PULC/person_exists/PPLCNet_x1_0.yaml

+ -c ./ppcls/configs/PULC/person_exists/PPLCNet_x1_0_search.yaml

```

-为了方便性能对比,我们也提供了大模型 SwinTransformer 和轻量模型 MobileNetV3 的配置文件,您可以使用命令训练:

+为了方便性能对比,我们也提供了大模型 SwinTransformer_tiny 和轻量模型 MobileNetV3_small_x0_35 的配置文件,您可以使用命令训练:

-SwinTransformer:

+SwinTransformer_tiny:

```shell

export CUDA_VISIBLE_DEVICES=0,1,2,3

@@ -128,7 +128,7 @@ python3 -m paddle.distributed.launch \

-c ./ppcls/configs/PULC/person_exists/SwinTransformer_tiny_patch4_window7_224.yaml

```

-MobileNetV3:

+MobileNetV3_small_x0_35:

```shell

export CUDA_VISIBLE_DEVICES=0,1,2,3

diff --git a/docs/zh_CN/PULC/PULC_vehicle_attribute.md b/docs/zh_CN/PULC/PULC_vehicle_attribute.md

index 1f5236895..2469aa440 100644

--- a/docs/zh_CN/PULC/PULC_vehicle_attribute.md

+++ b/docs/zh_CN/PULC/PULC_vehicle_attribute.md

@@ -7,6 +7,9 @@

- [1. 模型和应用场景介绍](#1)

- [2. 模型快速体验](#2)

+ - [2.1 安装 paddlepaddle](#2.1)

+ - [2.2 安装 paddleclas](#2.2)

+ - [2.3 预测](#2.3)

- [3. 模型训练、评估和预测](#3)

- [3.1 环境配置](#3.1)

- [3.2 数据准备](#3.2)

@@ -64,29 +67,50 @@

## 2. 模型快速体验

-

-### 2.1 安装 paddleclas

-

-使用如下命令快速安装 paddlepaddle, paddleclas

+

+### 2.1 安装 paddlepaddle

+

+- 您的机器安装的是 CUDA9 或 CUDA10,请运行以下命令安装

```bash

-pip3 install paddlepaddle paddleclas

+python3 -m pip install paddlepaddle-gpu -i https://mirror.baidu.com/pypi/simple

```

-

-### 2.2 预测

+- 您的机器是CPU,请运行以下命令安装

+

+```bash

+python3 -m pip install paddlepaddle -i https://mirror.baidu.com/pypi/simple

+```

+

+更多的版本需求,请参照[飞桨官网安装文档](https://www.paddlepaddle.org.cn/install/quick)中的说明进行操作。

+

+

+

+### 2.2 安装 paddleclas

+

+使用如下命令快速安装 paddleclas

+

+```

+pip3 install paddleclas

+```

+

+

+

+### 2.3 预测

+

+点击[这里](https://paddleclas.bj.bcebos.com/data/PULC/pulc_demo_imgs.zip)下载 demo 数据并解压,然后在终端中切换到相应目录。

* 使用命令行快速预测

```bash

-paddleclas --model_name vehicle_attribute --infer_imgs deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg

+paddleclas --model_name=vehicle_attribute --infer_imgs=pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg

```

结果如下:

```

>>> result

-attributes: Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505), output: [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], filename: deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg

-ppcls INFO: Predict complete!

+attributes: Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505), output: [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], filename: pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg

+Predict complete!

```

**备注**: 更换其他预测的数据时,只需要改变 `--infer_imgs=xx` 中的字段即可,支持传入整个文件夹。

@@ -96,17 +120,18 @@ ppcls INFO: Predict complete!

```python

import paddleclas

model = paddleclas.PaddleClas(model_name="vehicle_attribute")

-result = model.predict(input_data="deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg")

+result = model.predict(input_data="pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg")

print(next(result))

```

-**备注**:`model.predict()` 为可迭代对象(`generator`),因此需要使用 `next()` 函数或 `for` 循环对其迭代调用。每次调用将以 `batch_size` 为单位进行一次预测,并返回预测结果, 默认 `batch_size` 为 1,如果需要更改 `batch_size`,实例化模型时,需要指定 `batch_size`,如 `model = paddleclas.PaddleClas(model_name="person_exists", batch_size=2)`, 使用默认的代码返回结果示例如下:

+**备注**:`model.predict()` 为可迭代对象(`generator`),因此需要使用 `next()` 函数或 `for` 循环对其迭代调用。每次调用将以 `batch_size` 为单位进行一次预测,并返回预测结果, 默认 `batch_size` 为 1,如果需要更改 `batch_size`,实例化模型时,需要指定 `batch_size`,如 `model = paddleclas.PaddleClas(model_name="vehicle_attribute", batch_size=2)`, 使用默认的代码返回结果示例如下:

```

-result

-[{'attributes': 'Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505)', 'output': [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], 'filename': 'deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg'}]

+>>> result

+[{'attributes': 'Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505)', 'output': [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], 'filename': 'pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg'}]

```

+

## 3. 模型训练、评估和预测

diff --git a/ppcls/arch/backbone/legendary_models/resnet.py b/ppcls/arch/backbone/legendary_models/resnet.py

index 551d326e0..48e52ca48 100644

--- a/ppcls/arch/backbone/legendary_models/resnet.py

+++ b/ppcls/arch/backbone/legendary_models/resnet.py

@@ -26,6 +26,7 @@ from paddle.nn.initializer import Uniform

from paddle.regularizer import L2Decay

import math

+from ppcls.utils import logger

from ppcls.arch.backbone.base.theseus_layer import TheseusLayer

from ppcls.utils.save_load import load_dygraph_pretrain, load_dygraph_pretrain_from_url

@@ -306,9 +307,9 @@ class ResNet(TheseusLayer):

list, tuple

)), "lr_mult_list should be in (list, tuple) but got {}".format(

type(self.lr_mult_list))

- assert len(self.lr_mult_list

- ) == 5, "lr_mult_list length should be 5 but got {}".format(

- len(self.lr_mult_list))

+ if len(self.lr_mult_list) != 5:

+ msg = "lr_mult_list length should be 5 but got {}, default lr_mult_list used".format(len(self.lr_mult_list))

+ logger.warning(msg)

assert isinstance(self.stride_list, (

list, tuple

diff --git a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml

index 4cc98b311..5362d07b7 100644

--- a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml

+++ b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml

@@ -54,7 +54,7 @@ DataLoader:

dataset:

name: ImageNetDataset

image_root: ./dataset/

- cls_label_path: ./dataset/tt100k_clas_v2/label_list_train.txt

+ cls_label_path: ./dataset/traffic_sign/label_list_train.txt

delimiter: "\t"

transform_ops:

- DecodeImage:

diff --git a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml

index bbac87a53..27fbc4b86 100644

--- a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml

+++ b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml

@@ -118,8 +118,7 @@ DataLoader:

use_shared_memory: True

Infer:

- # infer_imgs: dataset/traffic_sign_demo/

- infer_imgs: dataset/tt100k_clas_v2/test/

+ infer_imgs: deploy/images/PULC/traffic_sign/99603_17806.jpg

batch_size: 10

transforms:

- DecodeImage:

diff --git a/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml b/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml

index 680ffe357..ae86ae622 100644

--- a/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml

+++ b/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml

@@ -113,7 +113,7 @@ DataLoader:

dataset:

name: ImageNetDataset

image_root: ./dataset/

- cls_label_path: ./dataset/tt100k_clas_v2/label_list_test.txt

+ cls_label_path: ./dataset/traffic_sign/label_list_test.txt

delimiter: "\t"

transform_ops:

- DecodeImage:

diff --git a/test_tipc/benchmark_train.sh b/test_tipc/benchmark_train.sh

index 793b89476..5c4d4112a 100644

--- a/test_tipc/benchmark_train.sh

+++ b/test_tipc/benchmark_train.sh

@@ -225,7 +225,7 @@ for batch_size in ${batch_size_list[*]}; do

echo $cmd

eval $cmd

last_status=${PIPESTATUS[0]}

- status_check $last_status "${cmd}" "${status_log}"

+ status_check $last_status "${cmd}" "${status_log}" "${model_name}"

else

IFS=";"

unset_env=`unset CUDA_VISIBLE_DEVICES`

@@ -261,7 +261,7 @@ for batch_size in ${batch_size_list[*]}; do

echo $cmd

eval $cmd

last_status=${PIPESTATUS[0]}

- status_check $last_status "${cmd}" "${status_log}"

+ status_check $last_status "${cmd}" "${status_log}" "${model_name}"

fi

done

done

diff --git a/test_tipc/common_func.sh b/test_tipc/common_func.sh

index 63fa10144..e0459366e 100644

--- a/test_tipc/common_func.sh

+++ b/test_tipc/common_func.sh

@@ -38,6 +38,7 @@ function func_set_params(){

function func_parser_params(){

strs=$1

+ MODE=$2

IFS=":"

array=(${strs})

key=${array[0]}

@@ -64,10 +65,10 @@ function status_check(){

last_status=$1 # the exit code

run_command=$2

run_log=$3

+ model_name=$4

if [ $last_status -eq 0 ]; then

- echo -e "\033[33m Run successfully with command - ${run_command}! \033[0m" | tee -a ${run_log}

+ echo -e "\033[33m Run successfully with command - ${model_name} - ${run_command}! \033[0m" | tee -a ${run_log}

else

- echo -e "\033[33m Run failed with command - ${run_command}! \033[0m" | tee -a ${run_log}

+ echo -e "\033[33m Run failed with command - ${model_name} - ${run_command}! \033[0m" | tee -a ${run_log}

fi

}

-

diff --git a/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index b6606beb2..1b970569a 100644

--- a/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -6,7 +6,7 @@ python:python3.7

--model_filename:inference.pdmodel

--params_filename:inference.pdiparams

--save_file:./deploy/models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer/inference.onnx

---opset_version:10

+--opset_version:11

--enable_onnx_checker:True

inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/rec/models/inference/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer.tar

inference:./python/predict_cls.py

diff --git a/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 86e2658ac..0b65824c3 100644

--- a/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -8,6 +8,7 @@ python:python3.7

--save_file:./deploy/models/PPHGNet_small_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPHGNet_small_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

Global.inference_model_dir:./models/PPHGNet_small_infer

diff --git a/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index c566fcb7e..b31ff8c60 100644

--- a/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -8,6 +8,7 @@ python:python3.7

--save_file:./deploy/models/PPHGNet_tiny_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPHGNet_tiny_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

Global.inference_model_dir:./models/PPHGNet_tiny_infer

diff --git a/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 6a89762ec..62dcb630b 100644

--- a/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -8,6 +8,7 @@ python:python3.7

--save_file:./deploy/models/PPLCNet_x0_25_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_25_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

Global.inference_model_dir:./models/PPLCNet_x0_25_infer

diff --git a/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 62dcb630b..427d8cc72 100644

--- a/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -1,16 +1,16 @@

===========================paddle2onnx_params===========================

-model_name:PPLCNet_x0_25

+model_name:PPLCNet_x0_35

python:python3.7

2onnx: paddle2onnx

---model_dir:./deploy/models/PPLCNet_x0_25_infer/

+--model_dir:./deploy/models/PPLCNet_x0_35_infer/

--model_filename:inference.pdmodel

--params_filename:inference.pdiparams

---save_file:./deploy/models/PPLCNet_x0_25_infer/inference.onnx

+--save_file:./deploy/models/PPLCNet_x0_35_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

-inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_25_infer.tar

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_35_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

-Global.inference_model_dir:./models/PPLCNet_x0_25_infer

+Global.inference_model_dir:./models/PPLCNet_x0_35_infer

Global.use_gpu:False

-c:configs/inference_cls.yaml

\ No newline at end of file

diff --git a/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index b6606beb2..c70ef6fc0 100644

--- a/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -1,16 +1,16 @@

===========================paddle2onnx_params===========================

-model_name:PP-ShiTu_mainbody_det

+model_name:PPLCNet_x0_5

python:python3.7

2onnx: paddle2onnx

---model_dir:./deploy/models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer/

+--model_dir:./deploy/models/PPLCNet_x0_5_infer/

--model_filename:inference.pdmodel

--params_filename:inference.pdiparams

---save_file:./deploy/models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer/inference.onnx

+--save_file:./deploy/models/PPLCNet_x0_5_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

-inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/rec/models/inference/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer.tar

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_5_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

-Global.inference_model_dir:./models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer

+Global.inference_model_dir:./models/PPLCNet_x0_5_infer

Global.use_gpu:False

-c:configs/inference_cls.yaml

\ No newline at end of file

diff --git a/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 64ca64494..82806311e 100644

--- a/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -9,8 +9,8 @@ python:python3.7

--opset_version:10

--enable_onnx_checker:True

inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/ResNet50_vd_infer.tar

-inference: python/predict_cls.py -c configs/inference_cls.yaml

+inference:./python/predict_cls.py

Global.use_onnx:True

-Global.inference_model_dir:models/ResNet50_vd_infer/

+Global.inference_model_dir:./models/ResNet50_vd_infer/

Global.use_gpu:False

-c:configs/inference_cls.yaml

diff --git a/test_tipc/prepare.sh b/test_tipc/prepare.sh

index 7951412fb..ca7b6a5b6 100644

--- a/test_tipc/prepare.sh

+++ b/test_tipc/prepare.sh

@@ -240,7 +240,7 @@ if [[ ${MODE} = "paddle2onnx_infer" ]]; then

inference_model_url=$(func_parser_value "${lines[10]}")

tar_name=${inference_model_url##*/}

- ${python_name} -m pip install install paddle2onnx

+ ${python_name} -m pip install paddle2onnx

${python_name} -m pip install onnxruntime

cd deploy

mkdir models

diff --git a/test_tipc/test_inference_cpp.sh b/test_tipc/test_inference_cpp.sh

index 0821751c2..abba66503 100644

--- a/test_tipc/test_inference_cpp.sh

+++ b/test_tipc/test_inference_cpp.sh

@@ -63,7 +63,7 @@ function func_shitu_cpp_inference(){

command="${_script} > ${_save_log_path} 2>&1"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

done

done

done

@@ -87,7 +87,7 @@ function func_shitu_cpp_inference(){

command="${_script} > ${_save_log_path} 2>&1"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

done

done

done

@@ -125,7 +125,7 @@ function func_cls_cpp_inference(){

command1="${_script} > ${_save_log_path} 2>&1"

eval ${command1}

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command1}" "${status_log}"

+ status_check $last_status "${command1}" "${status_log}" "${model_name}"

done

done

done

@@ -148,7 +148,7 @@ function func_cls_cpp_inference(){

command="${_script} > ${_save_log_path} 2>&1"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

done

done

done

diff --git a/test_tipc/test_inference_jeston.sh b/test_tipc/test_inference_jeston.sh

index 2fd76e1e9..568450039 100644

--- a/test_tipc/test_inference_jeston.sh

+++ b/test_tipc/test_inference_jeston.sh

@@ -71,7 +71,7 @@ if [ ${MODE} = "whole_infer" ]; then

echo $export_cmd

eval $export_cmd

status_export=$?

- status_check $status_export "${export_cmd}" "${status_log}"

+ status_check $status_export "${export_cmd}" "${status_log}" "${model_name}"

else

save_infer_dir=${infer_model}

fi

diff --git a/test_tipc/test_lite_arm_cpu_cpp.sh b/test_tipc/test_lite_arm_cpu_cpp.sh

index 86c340060..919226eea 100644

--- a/test_tipc/test_lite_arm_cpu_cpp.sh

+++ b/test_tipc/test_lite_arm_cpu_cpp.sh

@@ -67,7 +67,7 @@ function func_test_tipc(){

eval ${command1}

command2="adb shell 'export LD_LIBRARY_PATH=${lite_arm_work_path}; ${real_inference_cmd}' > ${_save_log_path} 2>&1"

eval ${command2}

- status_check $? "${command2}" "${status_log}"

+ status_check $? "${command2}" "${status_log}" "${model_name}"

done

done

done

diff --git a/test_tipc/test_paddle2onnx.sh b/test_tipc/test_paddle2onnx.sh

index fd2f1d90e..c869f8f3b 100644

--- a/test_tipc/test_paddle2onnx.sh

+++ b/test_tipc/test_paddle2onnx.sh

@@ -3,13 +3,6 @@ source test_tipc/common_func.sh

FILENAME=$1

-dataline=$(cat ${FILENAME})

-lines=(${dataline})

-# common params

-model_name=$(func_parser_value "${lines[1]}")

-python=$(func_parser_value "${lines[2]}")

-

-

# parser params

dataline=$(awk 'NR==1, NR==16{print}' $FILENAME)

IFS=$'\n'

@@ -43,7 +36,7 @@ inference_config_key=$(func_parser_key "${lines[15]}")

inference_config_value=$(func_parser_value "${lines[15]}")

LOG_PATH="./test_tipc/output/${model_name}"

-mkdir -p ./test_tipc/output

+mkdir -p ${LOG_PATH}

status_log="${LOG_PATH}/results_paddle2onnx.log"

@@ -62,7 +55,8 @@ function func_paddle2onnx(){

trans_model_cmd="${padlle2onnx_cmd} ${set_dirname} ${set_model_filename} ${set_params_filename} ${set_save_model} ${set_opset_version} ${set_enable_onnx_checker}"

eval $trans_model_cmd

last_status=${PIPESTATUS[0]}

- status_check $last_status "${trans_model_cmd}" "${status_log}"

+ status_check $last_status "${trans_model_cmd}" "${status_log}" "${model_name}"

+

# python inference

set_model_dir=$(func_set_params "${inference_model_dir_key}" "${inference_model_dir_value}")

set_use_onnx=$(func_set_params "${use_onnx_key}" "${use_onnx_value}")

@@ -70,7 +64,7 @@ function func_paddle2onnx(){

set_inference_config=$(func_set_params "${inference_config_key}" "${inference_config_value}")

infer_model_cmd="cd deploy && ${python} ${inference_py} -o ${set_model_dir} -o ${set_use_onnx} -o ${set_hardware} ${set_inference_config} > ${_save_log_path} 2>&1 && cd ../"

eval $infer_model_cmd

- status_check $last_status "${infer_model_cmd}" "${status_log}"

+ status_check $last_status "${infer_model_cmd}" "${status_log}" "${model_name}"

}

diff --git a/test_tipc/test_train_inference_python.sh b/test_tipc/test_train_inference_python.sh

index 2f2b3b65a..427005cf0 100644

--- a/test_tipc/test_train_inference_python.sh

+++ b/test_tipc/test_train_inference_python.sh

@@ -126,7 +126,7 @@ function func_inference(){

eval $command

last_status=${PIPESTATUS[0]}

eval "cat ${_save_log_path}"

- status_check $last_status "${command}" "../${status_log}"

+ status_check $last_status "${command}" "../${status_log}" "${model_name}"

done

done

done

@@ -151,7 +151,7 @@ function func_inference(){

eval $command

last_status=${PIPESTATUS[0]}

eval "cat ${_save_log_path}"

- status_check $last_status "${command}" "../${status_log}"

+ status_check $last_status "${command}" "../${status_log}" "${model_name}"

done

done

done

@@ -198,7 +198,7 @@ elif [[ ${MODE} = "klquant_whole_infer" ]]; then

command="${python} ${kl_quant_cmd_value}"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

cd inference/quant_post_static_model

ln -s __model__ inference.pdmodel

ln -s __params__ inference.pdiparams

@@ -301,7 +301,7 @@ else

# export FLAGS_cudnn_deterministic=True

sleep 5

eval $cmd

- status_check $? "${cmd}" "${status_log}"

+ status_check $? "${cmd}" "${status_log}" "${model_name}"

sleep 5

if [[ $FILENAME == *GeneralRecognition* ]]; then

@@ -318,7 +318,7 @@ else

set_eval_params1=$(func_set_params "${eval_key1}" "${eval_value1}")

eval_cmd="${python} ${eval_py} ${set_eval_pretrain} ${set_use_gpu} ${set_eval_params1}"

eval $eval_cmd

- status_check $? "${eval_cmd}" "${status_log}"

+ status_check $? "${eval_cmd}" "${status_log}" "${model_name}"

sleep 5

fi

# run export model

@@ -333,7 +333,7 @@ else

set_save_infer_key=$(func_set_params "${save_infer_key}" "${save_infer_path}")

export_cmd="${python} ${run_export} ${set_export_weight} ${set_save_infer_key}"

eval $export_cmd

- status_check $? "${export_cmd}" "${status_log}"

+ status_check $? "${export_cmd}" "${status_log}" "${model_name}"

#run inference

eval $env

diff --git a/tools/export_model.py b/tools/export_model.py

index 01aba06c1..35f432f50 100644

--- a/tools/export_model.py

+++ b/tools/export_model.py

@@ -30,5 +30,7 @@ if __name__ == "__main__":

args = config.parse_args()

config = config.get_config(

args.config, overrides=args.override, show=False)

+ if config["Arch"].get("use_sync_bn", False):

+ config["Arch"]["use_sync_bn"] = False

engine = Engine(config, mode="export")

engine.export()

@@ -78,7 +78,7 @@ train

tree -r -i -f train | grep -E "jpg|JPG|jpeg|JPEG|png|PNG" | awk -F "/" '{print $0" "$2}' > train_list.txt

```

-其中,如果需要传入更多的数据类型,可以增加 `grep -E`后的内容, `$2`中的`2`为类别号文件夹的层级。

+其中,如果涉及更多的图片名称尾缀,可以增加 `grep -E`后的内容, `$2` 中的 `2` 为类别号文件夹的层级。

**备注:** 以上为数据集获取和生成的方法介绍,这里您可以直接下载有人/无人场景数据快速开始体验。

@@ -105,20 +105,20 @@ cd ../

#### 3.1 骨干网络PP-LCNet

-PULC采用了轻量骨干网络PP-LCNet,相比同精度竞品速度快50%,您可以在[PP-LCNet介绍](../models/PP-LCNet.md)查阅该骨干网络的详细介绍。

-直接使用PP-LCNet训练的命令为:

+PULC 采用了轻量骨干网络 PP-LCNet,相比同精度竞品速度快 50%,您可以在[PP-LCNet介绍](../models/PP-LCNet.md)查阅该骨干网络的详细介绍。

+直接使用 PP-LCNet 训练的命令为:

```shell

export CUDA_VISIBLE_DEVICES=0,1,2,3

python3 -m paddle.distributed.launch \

--gpus="0,1,2,3" \

tools/train.py \

- -c ./ppcls/configs/PULC/person_exists/PPLCNet_x1_0.yaml

+ -c ./ppcls/configs/PULC/person_exists/PPLCNet_x1_0_search.yaml

```

-为了方便性能对比,我们也提供了大模型 SwinTransformer 和轻量模型 MobileNetV3 的配置文件,您可以使用命令训练:

+为了方便性能对比,我们也提供了大模型 SwinTransformer_tiny 和轻量模型 MobileNetV3_small_x0_35 的配置文件,您可以使用命令训练:

-SwinTransformer:

+SwinTransformer_tiny:

```shell

export CUDA_VISIBLE_DEVICES=0,1,2,3

@@ -128,7 +128,7 @@ python3 -m paddle.distributed.launch \

-c ./ppcls/configs/PULC/person_exists/SwinTransformer_tiny_patch4_window7_224.yaml

```

-MobileNetV3:

+MobileNetV3_small_x0_35:

```shell

export CUDA_VISIBLE_DEVICES=0,1,2,3

diff --git a/docs/zh_CN/PULC/PULC_vehicle_attribute.md b/docs/zh_CN/PULC/PULC_vehicle_attribute.md

index 1f5236895..2469aa440 100644

--- a/docs/zh_CN/PULC/PULC_vehicle_attribute.md

+++ b/docs/zh_CN/PULC/PULC_vehicle_attribute.md

@@ -7,6 +7,9 @@

- [1. 模型和应用场景介绍](#1)

- [2. 模型快速体验](#2)

+ - [2.1 安装 paddlepaddle](#2.1)

+ - [2.2 安装 paddleclas](#2.2)

+ - [2.3 预测](#2.3)

- [3. 模型训练、评估和预测](#3)

- [3.1 环境配置](#3.1)

- [3.2 数据准备](#3.2)

@@ -64,29 +67,50 @@

## 2. 模型快速体验

-

-### 2.1 安装 paddleclas

-

-使用如下命令快速安装 paddlepaddle, paddleclas

+

+### 2.1 安装 paddlepaddle

+

+- 您的机器安装的是 CUDA9 或 CUDA10,请运行以下命令安装

```bash

-pip3 install paddlepaddle paddleclas

+python3 -m pip install paddlepaddle-gpu -i https://mirror.baidu.com/pypi/simple

```

-

-### 2.2 预测

+- 您的机器是CPU,请运行以下命令安装

+

+```bash

+python3 -m pip install paddlepaddle -i https://mirror.baidu.com/pypi/simple

+```

+

+更多的版本需求,请参照[飞桨官网安装文档](https://www.paddlepaddle.org.cn/install/quick)中的说明进行操作。

+

+

+

+### 2.2 安装 paddleclas

+

+使用如下命令快速安装 paddleclas

+

+```

+pip3 install paddleclas

+```

+

+

+

+### 2.3 预测

+

+点击[这里](https://paddleclas.bj.bcebos.com/data/PULC/pulc_demo_imgs.zip)下载 demo 数据并解压,然后在终端中切换到相应目录。

* 使用命令行快速预测

```bash

-paddleclas --model_name vehicle_attribute --infer_imgs deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg

+paddleclas --model_name=vehicle_attribute --infer_imgs=pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg

```

结果如下:

```

>>> result

-attributes: Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505), output: [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], filename: deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg

-ppcls INFO: Predict complete!

+attributes: Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505), output: [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], filename: pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg

+Predict complete!

```

**备注**: 更换其他预测的数据时,只需要改变 `--infer_imgs=xx` 中的字段即可,支持传入整个文件夹。

@@ -96,17 +120,18 @@ ppcls INFO: Predict complete!

```python

import paddleclas

model = paddleclas.PaddleClas(model_name="vehicle_attribute")

-result = model.predict(input_data="deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg")

+result = model.predict(input_data="pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg")

print(next(result))

```

-**备注**:`model.predict()` 为可迭代对象(`generator`),因此需要使用 `next()` 函数或 `for` 循环对其迭代调用。每次调用将以 `batch_size` 为单位进行一次预测,并返回预测结果, 默认 `batch_size` 为 1,如果需要更改 `batch_size`,实例化模型时,需要指定 `batch_size`,如 `model = paddleclas.PaddleClas(model_name="person_exists", batch_size=2)`, 使用默认的代码返回结果示例如下:

+**备注**:`model.predict()` 为可迭代对象(`generator`),因此需要使用 `next()` 函数或 `for` 循环对其迭代调用。每次调用将以 `batch_size` 为单位进行一次预测,并返回预测结果, 默认 `batch_size` 为 1,如果需要更改 `batch_size`,实例化模型时,需要指定 `batch_size`,如 `model = paddleclas.PaddleClas(model_name="vehicle_attribute", batch_size=2)`, 使用默认的代码返回结果示例如下:

```

-result

-[{'attributes': 'Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505)', 'output': [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], 'filename': 'deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg'}]

+>>> result

+[{'attributes': 'Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505)', 'output': [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], 'filename': 'pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg'}]

```

+

## 3. 模型训练、评估和预测

diff --git a/ppcls/arch/backbone/legendary_models/resnet.py b/ppcls/arch/backbone/legendary_models/resnet.py

index 551d326e0..48e52ca48 100644

--- a/ppcls/arch/backbone/legendary_models/resnet.py

+++ b/ppcls/arch/backbone/legendary_models/resnet.py

@@ -26,6 +26,7 @@ from paddle.nn.initializer import Uniform

from paddle.regularizer import L2Decay

import math

+from ppcls.utils import logger

from ppcls.arch.backbone.base.theseus_layer import TheseusLayer

from ppcls.utils.save_load import load_dygraph_pretrain, load_dygraph_pretrain_from_url

@@ -306,9 +307,9 @@ class ResNet(TheseusLayer):

list, tuple

)), "lr_mult_list should be in (list, tuple) but got {}".format(

type(self.lr_mult_list))

- assert len(self.lr_mult_list

- ) == 5, "lr_mult_list length should be 5 but got {}".format(

- len(self.lr_mult_list))

+ if len(self.lr_mult_list) != 5:

+ msg = "lr_mult_list length should be 5 but got {}, default lr_mult_list used".format(len(self.lr_mult_list))

+ logger.warning(msg)

assert isinstance(self.stride_list, (

list, tuple

diff --git a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml

index 4cc98b311..5362d07b7 100644

--- a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml

+++ b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml

@@ -54,7 +54,7 @@ DataLoader:

dataset:

name: ImageNetDataset

image_root: ./dataset/

- cls_label_path: ./dataset/tt100k_clas_v2/label_list_train.txt

+ cls_label_path: ./dataset/traffic_sign/label_list_train.txt

delimiter: "\t"

transform_ops:

- DecodeImage:

diff --git a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml

index bbac87a53..27fbc4b86 100644

--- a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml

+++ b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml

@@ -118,8 +118,7 @@ DataLoader:

use_shared_memory: True

Infer:

- # infer_imgs: dataset/traffic_sign_demo/

- infer_imgs: dataset/tt100k_clas_v2/test/

+ infer_imgs: deploy/images/PULC/traffic_sign/99603_17806.jpg

batch_size: 10

transforms:

- DecodeImage:

diff --git a/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml b/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml

index 680ffe357..ae86ae622 100644

--- a/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml

+++ b/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml

@@ -113,7 +113,7 @@ DataLoader:

dataset:

name: ImageNetDataset

image_root: ./dataset/

- cls_label_path: ./dataset/tt100k_clas_v2/label_list_test.txt

+ cls_label_path: ./dataset/traffic_sign/label_list_test.txt

delimiter: "\t"

transform_ops:

- DecodeImage:

diff --git a/test_tipc/benchmark_train.sh b/test_tipc/benchmark_train.sh

index 793b89476..5c4d4112a 100644

--- a/test_tipc/benchmark_train.sh

+++ b/test_tipc/benchmark_train.sh

@@ -225,7 +225,7 @@ for batch_size in ${batch_size_list[*]}; do

echo $cmd

eval $cmd

last_status=${PIPESTATUS[0]}

- status_check $last_status "${cmd}" "${status_log}"

+ status_check $last_status "${cmd}" "${status_log}" "${model_name}"

else

IFS=";"

unset_env=`unset CUDA_VISIBLE_DEVICES`

@@ -261,7 +261,7 @@ for batch_size in ${batch_size_list[*]}; do

echo $cmd

eval $cmd

last_status=${PIPESTATUS[0]}

- status_check $last_status "${cmd}" "${status_log}"

+ status_check $last_status "${cmd}" "${status_log}" "${model_name}"

fi

done

done

diff --git a/test_tipc/common_func.sh b/test_tipc/common_func.sh

index 63fa10144..e0459366e 100644

--- a/test_tipc/common_func.sh

+++ b/test_tipc/common_func.sh

@@ -38,6 +38,7 @@ function func_set_params(){

function func_parser_params(){

strs=$1

+ MODE=$2

IFS=":"

array=(${strs})

key=${array[0]}

@@ -64,10 +65,10 @@ function status_check(){

last_status=$1 # the exit code

run_command=$2

run_log=$3

+ model_name=$4

if [ $last_status -eq 0 ]; then

- echo -e "\033[33m Run successfully with command - ${run_command}! \033[0m" | tee -a ${run_log}

+ echo -e "\033[33m Run successfully with command - ${model_name} - ${run_command}! \033[0m" | tee -a ${run_log}

else

- echo -e "\033[33m Run failed with command - ${run_command}! \033[0m" | tee -a ${run_log}

+ echo -e "\033[33m Run failed with command - ${model_name} - ${run_command}! \033[0m" | tee -a ${run_log}

fi

}

-

diff --git a/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index b6606beb2..1b970569a 100644

--- a/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -6,7 +6,7 @@ python:python3.7

--model_filename:inference.pdmodel

--params_filename:inference.pdiparams

--save_file:./deploy/models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer/inference.onnx

---opset_version:10

+--opset_version:11

--enable_onnx_checker:True

inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/rec/models/inference/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer.tar

inference:./python/predict_cls.py

diff --git a/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 86e2658ac..0b65824c3 100644

--- a/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -8,6 +8,7 @@ python:python3.7

--save_file:./deploy/models/PPHGNet_small_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPHGNet_small_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

Global.inference_model_dir:./models/PPHGNet_small_infer

diff --git a/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index c566fcb7e..b31ff8c60 100644

--- a/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -8,6 +8,7 @@ python:python3.7

--save_file:./deploy/models/PPHGNet_tiny_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPHGNet_tiny_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

Global.inference_model_dir:./models/PPHGNet_tiny_infer

diff --git a/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 6a89762ec..62dcb630b 100644

--- a/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -8,6 +8,7 @@ python:python3.7

--save_file:./deploy/models/PPLCNet_x0_25_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_25_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

Global.inference_model_dir:./models/PPLCNet_x0_25_infer

diff --git a/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 62dcb630b..427d8cc72 100644

--- a/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -1,16 +1,16 @@

===========================paddle2onnx_params===========================

-model_name:PPLCNet_x0_25

+model_name:PPLCNet_x0_35

python:python3.7

2onnx: paddle2onnx

---model_dir:./deploy/models/PPLCNet_x0_25_infer/

+--model_dir:./deploy/models/PPLCNet_x0_35_infer/

--model_filename:inference.pdmodel

--params_filename:inference.pdiparams

---save_file:./deploy/models/PPLCNet_x0_25_infer/inference.onnx

+--save_file:./deploy/models/PPLCNet_x0_35_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

-inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_25_infer.tar

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_35_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

-Global.inference_model_dir:./models/PPLCNet_x0_25_infer

+Global.inference_model_dir:./models/PPLCNet_x0_35_infer

Global.use_gpu:False

-c:configs/inference_cls.yaml

\ No newline at end of file

diff --git a/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index b6606beb2..c70ef6fc0 100644

--- a/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -1,16 +1,16 @@

===========================paddle2onnx_params===========================

-model_name:PP-ShiTu_mainbody_det

+model_name:PPLCNet_x0_5

python:python3.7

2onnx: paddle2onnx

---model_dir:./deploy/models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer/

+--model_dir:./deploy/models/PPLCNet_x0_5_infer/

--model_filename:inference.pdmodel

--params_filename:inference.pdiparams

---save_file:./deploy/models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer/inference.onnx

+--save_file:./deploy/models/PPLCNet_x0_5_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

-inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/rec/models/inference/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer.tar

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_5_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

-Global.inference_model_dir:./models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer

+Global.inference_model_dir:./models/PPLCNet_x0_5_infer

Global.use_gpu:False

-c:configs/inference_cls.yaml

\ No newline at end of file

diff --git a/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 64ca64494..82806311e 100644

--- a/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -9,8 +9,8 @@ python:python3.7

--opset_version:10

--enable_onnx_checker:True

inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/ResNet50_vd_infer.tar

-inference: python/predict_cls.py -c configs/inference_cls.yaml

+inference:./python/predict_cls.py

Global.use_onnx:True

-Global.inference_model_dir:models/ResNet50_vd_infer/

+Global.inference_model_dir:./models/ResNet50_vd_infer/

Global.use_gpu:False

-c:configs/inference_cls.yaml

diff --git a/test_tipc/prepare.sh b/test_tipc/prepare.sh

index 7951412fb..ca7b6a5b6 100644

--- a/test_tipc/prepare.sh

+++ b/test_tipc/prepare.sh

@@ -240,7 +240,7 @@ if [[ ${MODE} = "paddle2onnx_infer" ]]; then

inference_model_url=$(func_parser_value "${lines[10]}")

tar_name=${inference_model_url##*/}

- ${python_name} -m pip install install paddle2onnx

+ ${python_name} -m pip install paddle2onnx

${python_name} -m pip install onnxruntime

cd deploy

mkdir models

diff --git a/test_tipc/test_inference_cpp.sh b/test_tipc/test_inference_cpp.sh

index 0821751c2..abba66503 100644

--- a/test_tipc/test_inference_cpp.sh

+++ b/test_tipc/test_inference_cpp.sh

@@ -63,7 +63,7 @@ function func_shitu_cpp_inference(){

command="${_script} > ${_save_log_path} 2>&1"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

done

done

done

@@ -87,7 +87,7 @@ function func_shitu_cpp_inference(){

command="${_script} > ${_save_log_path} 2>&1"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

done

done

done

@@ -125,7 +125,7 @@ function func_cls_cpp_inference(){

command1="${_script} > ${_save_log_path} 2>&1"

eval ${command1}

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command1}" "${status_log}"

+ status_check $last_status "${command1}" "${status_log}" "${model_name}"

done

done

done

@@ -148,7 +148,7 @@ function func_cls_cpp_inference(){

command="${_script} > ${_save_log_path} 2>&1"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

done

done

done

diff --git a/test_tipc/test_inference_jeston.sh b/test_tipc/test_inference_jeston.sh

index 2fd76e1e9..568450039 100644

--- a/test_tipc/test_inference_jeston.sh

+++ b/test_tipc/test_inference_jeston.sh

@@ -71,7 +71,7 @@ if [ ${MODE} = "whole_infer" ]; then

echo $export_cmd

eval $export_cmd

status_export=$?

- status_check $status_export "${export_cmd}" "${status_log}"

+ status_check $status_export "${export_cmd}" "${status_log}" "${model_name}"

else

save_infer_dir=${infer_model}

fi

diff --git a/test_tipc/test_lite_arm_cpu_cpp.sh b/test_tipc/test_lite_arm_cpu_cpp.sh

index 86c340060..919226eea 100644

--- a/test_tipc/test_lite_arm_cpu_cpp.sh

+++ b/test_tipc/test_lite_arm_cpu_cpp.sh

@@ -67,7 +67,7 @@ function func_test_tipc(){

eval ${command1}

command2="adb shell 'export LD_LIBRARY_PATH=${lite_arm_work_path}; ${real_inference_cmd}' > ${_save_log_path} 2>&1"

eval ${command2}

- status_check $? "${command2}" "${status_log}"

+ status_check $? "${command2}" "${status_log}" "${model_name}"

done

done

done

diff --git a/test_tipc/test_paddle2onnx.sh b/test_tipc/test_paddle2onnx.sh

index fd2f1d90e..c869f8f3b 100644

--- a/test_tipc/test_paddle2onnx.sh

+++ b/test_tipc/test_paddle2onnx.sh

@@ -3,13 +3,6 @@ source test_tipc/common_func.sh

FILENAME=$1

-dataline=$(cat ${FILENAME})

-lines=(${dataline})

-# common params

-model_name=$(func_parser_value "${lines[1]}")

-python=$(func_parser_value "${lines[2]}")

-

-

# parser params

dataline=$(awk 'NR==1, NR==16{print}' $FILENAME)

IFS=$'\n'

@@ -43,7 +36,7 @@ inference_config_key=$(func_parser_key "${lines[15]}")

inference_config_value=$(func_parser_value "${lines[15]}")

LOG_PATH="./test_tipc/output/${model_name}"

-mkdir -p ./test_tipc/output

+mkdir -p ${LOG_PATH}

status_log="${LOG_PATH}/results_paddle2onnx.log"

@@ -62,7 +55,8 @@ function func_paddle2onnx(){

trans_model_cmd="${padlle2onnx_cmd} ${set_dirname} ${set_model_filename} ${set_params_filename} ${set_save_model} ${set_opset_version} ${set_enable_onnx_checker}"

eval $trans_model_cmd

last_status=${PIPESTATUS[0]}

- status_check $last_status "${trans_model_cmd}" "${status_log}"

+ status_check $last_status "${trans_model_cmd}" "${status_log}" "${model_name}"

+

# python inference

set_model_dir=$(func_set_params "${inference_model_dir_key}" "${inference_model_dir_value}")

set_use_onnx=$(func_set_params "${use_onnx_key}" "${use_onnx_value}")

@@ -70,7 +64,7 @@ function func_paddle2onnx(){

set_inference_config=$(func_set_params "${inference_config_key}" "${inference_config_value}")

infer_model_cmd="cd deploy && ${python} ${inference_py} -o ${set_model_dir} -o ${set_use_onnx} -o ${set_hardware} ${set_inference_config} > ${_save_log_path} 2>&1 && cd ../"

eval $infer_model_cmd

- status_check $last_status "${infer_model_cmd}" "${status_log}"

+ status_check $last_status "${infer_model_cmd}" "${status_log}" "${model_name}"

}

diff --git a/test_tipc/test_train_inference_python.sh b/test_tipc/test_train_inference_python.sh

index 2f2b3b65a..427005cf0 100644

--- a/test_tipc/test_train_inference_python.sh

+++ b/test_tipc/test_train_inference_python.sh

@@ -126,7 +126,7 @@ function func_inference(){

eval $command

last_status=${PIPESTATUS[0]}

eval "cat ${_save_log_path}"

- status_check $last_status "${command}" "../${status_log}"

+ status_check $last_status "${command}" "../${status_log}" "${model_name}"

done

done

done

@@ -151,7 +151,7 @@ function func_inference(){

eval $command

last_status=${PIPESTATUS[0]}

eval "cat ${_save_log_path}"

- status_check $last_status "${command}" "../${status_log}"

+ status_check $last_status "${command}" "../${status_log}" "${model_name}"

done

done

done

@@ -198,7 +198,7 @@ elif [[ ${MODE} = "klquant_whole_infer" ]]; then

command="${python} ${kl_quant_cmd_value}"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

cd inference/quant_post_static_model

ln -s __model__ inference.pdmodel

ln -s __params__ inference.pdiparams

@@ -301,7 +301,7 @@ else

# export FLAGS_cudnn_deterministic=True

sleep 5

eval $cmd

- status_check $? "${cmd}" "${status_log}"

+ status_check $? "${cmd}" "${status_log}" "${model_name}"

sleep 5

if [[ $FILENAME == *GeneralRecognition* ]]; then

@@ -318,7 +318,7 @@ else

set_eval_params1=$(func_set_params "${eval_key1}" "${eval_value1}")

eval_cmd="${python} ${eval_py} ${set_eval_pretrain} ${set_use_gpu} ${set_eval_params1}"

eval $eval_cmd

- status_check $? "${eval_cmd}" "${status_log}"

+ status_check $? "${eval_cmd}" "${status_log}" "${model_name}"

sleep 5

fi

# run export model

@@ -333,7 +333,7 @@ else

set_save_infer_key=$(func_set_params "${save_infer_key}" "${save_infer_path}")

export_cmd="${python} ${run_export} ${set_export_weight} ${set_save_infer_key}"

eval $export_cmd

- status_check $? "${export_cmd}" "${status_log}"

+ status_check $? "${export_cmd}" "${status_log}" "${model_name}"

#run inference

eval $env

diff --git a/tools/export_model.py b/tools/export_model.py

index 01aba06c1..35f432f50 100644

--- a/tools/export_model.py

+++ b/tools/export_model.py

@@ -30,5 +30,7 @@ if __name__ == "__main__":

args = config.parse_args()

config = config.get_config(

args.config, overrides=args.override, show=False)

+ if config["Arch"].get("use_sync_bn", False):

+ config["Arch"]["use_sync_bn"] = False

engine = Engine(config, mode="export")

engine.export()

@@ -78,7 +78,7 @@ train

tree -r -i -f train | grep -E "jpg|JPG|jpeg|JPEG|png|PNG" | awk -F "/" '{print $0" "$2}' > train_list.txt

```

-其中,如果需要传入更多的数据类型,可以增加 `grep -E`后的内容, `$2`中的`2`为类别号文件夹的层级。

+其中,如果涉及更多的图片名称尾缀,可以增加 `grep -E`后的内容, `$2` 中的 `2` 为类别号文件夹的层级。

**备注:** 以上为数据集获取和生成的方法介绍,这里您可以直接下载有人/无人场景数据快速开始体验。

@@ -105,20 +105,20 @@ cd ../

#### 3.1 骨干网络PP-LCNet

-PULC采用了轻量骨干网络PP-LCNet,相比同精度竞品速度快50%,您可以在[PP-LCNet介绍](../models/PP-LCNet.md)查阅该骨干网络的详细介绍。

-直接使用PP-LCNet训练的命令为:

+PULC 采用了轻量骨干网络 PP-LCNet,相比同精度竞品速度快 50%,您可以在[PP-LCNet介绍](../models/PP-LCNet.md)查阅该骨干网络的详细介绍。

+直接使用 PP-LCNet 训练的命令为:

```shell

export CUDA_VISIBLE_DEVICES=0,1,2,3

python3 -m paddle.distributed.launch \

--gpus="0,1,2,3" \

tools/train.py \

- -c ./ppcls/configs/PULC/person_exists/PPLCNet_x1_0.yaml

+ -c ./ppcls/configs/PULC/person_exists/PPLCNet_x1_0_search.yaml

```

-为了方便性能对比,我们也提供了大模型 SwinTransformer 和轻量模型 MobileNetV3 的配置文件,您可以使用命令训练:

+为了方便性能对比,我们也提供了大模型 SwinTransformer_tiny 和轻量模型 MobileNetV3_small_x0_35 的配置文件,您可以使用命令训练:

-SwinTransformer:

+SwinTransformer_tiny:

```shell

export CUDA_VISIBLE_DEVICES=0,1,2,3

@@ -128,7 +128,7 @@ python3 -m paddle.distributed.launch \

-c ./ppcls/configs/PULC/person_exists/SwinTransformer_tiny_patch4_window7_224.yaml

```

-MobileNetV3:

+MobileNetV3_small_x0_35:

```shell

export CUDA_VISIBLE_DEVICES=0,1,2,3

diff --git a/docs/zh_CN/PULC/PULC_vehicle_attribute.md b/docs/zh_CN/PULC/PULC_vehicle_attribute.md

index 1f5236895..2469aa440 100644

--- a/docs/zh_CN/PULC/PULC_vehicle_attribute.md

+++ b/docs/zh_CN/PULC/PULC_vehicle_attribute.md

@@ -7,6 +7,9 @@

- [1. 模型和应用场景介绍](#1)

- [2. 模型快速体验](#2)

+ - [2.1 安装 paddlepaddle](#2.1)

+ - [2.2 安装 paddleclas](#2.2)

+ - [2.3 预测](#2.3)

- [3. 模型训练、评估和预测](#3)

- [3.1 环境配置](#3.1)

- [3.2 数据准备](#3.2)

@@ -64,29 +67,50 @@

## 2. 模型快速体验

-

-### 2.1 安装 paddleclas

-

-使用如下命令快速安装 paddlepaddle, paddleclas

+

+### 2.1 安装 paddlepaddle

+

+- 您的机器安装的是 CUDA9 或 CUDA10,请运行以下命令安装

```bash

-pip3 install paddlepaddle paddleclas

+python3 -m pip install paddlepaddle-gpu -i https://mirror.baidu.com/pypi/simple

```

-

-### 2.2 预测

+- 您的机器是CPU,请运行以下命令安装

+

+```bash

+python3 -m pip install paddlepaddle -i https://mirror.baidu.com/pypi/simple

+```

+

+更多的版本需求,请参照[飞桨官网安装文档](https://www.paddlepaddle.org.cn/install/quick)中的说明进行操作。

+

+

+

+### 2.2 安装 paddleclas

+

+使用如下命令快速安装 paddleclas

+

+```

+pip3 install paddleclas

+```

+

+

+

+### 2.3 预测

+

+点击[这里](https://paddleclas.bj.bcebos.com/data/PULC/pulc_demo_imgs.zip)下载 demo 数据并解压,然后在终端中切换到相应目录。

* 使用命令行快速预测

```bash

-paddleclas --model_name vehicle_attribute --infer_imgs deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg

+paddleclas --model_name=vehicle_attribute --infer_imgs=pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg

```

结果如下:

```

>>> result

-attributes: Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505), output: [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], filename: deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg

-ppcls INFO: Predict complete!

+attributes: Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505), output: [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], filename: pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg

+Predict complete!

```

**备注**: 更换其他预测的数据时,只需要改变 `--infer_imgs=xx` 中的字段即可,支持传入整个文件夹。

@@ -96,17 +120,18 @@ ppcls INFO: Predict complete!

```python

import paddleclas

model = paddleclas.PaddleClas(model_name="vehicle_attribute")

-result = model.predict(input_data="deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg")

+result = model.predict(input_data="pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg")

print(next(result))

```

-**备注**:`model.predict()` 为可迭代对象(`generator`),因此需要使用 `next()` 函数或 `for` 循环对其迭代调用。每次调用将以 `batch_size` 为单位进行一次预测,并返回预测结果, 默认 `batch_size` 为 1,如果需要更改 `batch_size`,实例化模型时,需要指定 `batch_size`,如 `model = paddleclas.PaddleClas(model_name="person_exists", batch_size=2)`, 使用默认的代码返回结果示例如下:

+**备注**:`model.predict()` 为可迭代对象(`generator`),因此需要使用 `next()` 函数或 `for` 循环对其迭代调用。每次调用将以 `batch_size` 为单位进行一次预测,并返回预测结果, 默认 `batch_size` 为 1,如果需要更改 `batch_size`,实例化模型时,需要指定 `batch_size`,如 `model = paddleclas.PaddleClas(model_name="vehicle_attribute", batch_size=2)`, 使用默认的代码返回结果示例如下:

```

-result

-[{'attributes': 'Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505)', 'output': [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], 'filename': 'deploy/images/PULC/vehicle_attribute/0002_c002_00030670_0.jpg'}]

+>>> result

+[{'attributes': 'Color: (yellow, prob: 0.9893476963043213), Type: (hatchback, prob: 0.9734097719192505)', 'output': [1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0], 'filename': 'pulc_demo_imgs/vehicle_attribute/0002_c002_00030670_0.jpg'}]

```

+

## 3. 模型训练、评估和预测

diff --git a/ppcls/arch/backbone/legendary_models/resnet.py b/ppcls/arch/backbone/legendary_models/resnet.py

index 551d326e0..48e52ca48 100644

--- a/ppcls/arch/backbone/legendary_models/resnet.py

+++ b/ppcls/arch/backbone/legendary_models/resnet.py

@@ -26,6 +26,7 @@ from paddle.nn.initializer import Uniform

from paddle.regularizer import L2Decay

import math

+from ppcls.utils import logger

from ppcls.arch.backbone.base.theseus_layer import TheseusLayer

from ppcls.utils.save_load import load_dygraph_pretrain, load_dygraph_pretrain_from_url

@@ -306,9 +307,9 @@ class ResNet(TheseusLayer):

list, tuple

)), "lr_mult_list should be in (list, tuple) but got {}".format(

type(self.lr_mult_list))

- assert len(self.lr_mult_list

- ) == 5, "lr_mult_list length should be 5 but got {}".format(

- len(self.lr_mult_list))

+ if len(self.lr_mult_list) != 5:

+ msg = "lr_mult_list length should be 5 but got {}, default lr_mult_list used".format(len(self.lr_mult_list))

+ logger.warning(msg)

assert isinstance(self.stride_list, (

list, tuple

diff --git a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml

index 4cc98b311..5362d07b7 100644

--- a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml

+++ b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0.yaml

@@ -54,7 +54,7 @@ DataLoader:

dataset:

name: ImageNetDataset

image_root: ./dataset/

- cls_label_path: ./dataset/tt100k_clas_v2/label_list_train.txt

+ cls_label_path: ./dataset/traffic_sign/label_list_train.txt

delimiter: "\t"

transform_ops:

- DecodeImage:

diff --git a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml

index bbac87a53..27fbc4b86 100644

--- a/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml

+++ b/ppcls/configs/PULC/traffic_sign/PPLCNet_x1_0_search.yaml

@@ -118,8 +118,7 @@ DataLoader:

use_shared_memory: True

Infer:

- # infer_imgs: dataset/traffic_sign_demo/

- infer_imgs: dataset/tt100k_clas_v2/test/

+ infer_imgs: deploy/images/PULC/traffic_sign/99603_17806.jpg

batch_size: 10

transforms:

- DecodeImage:

diff --git a/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml b/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml

index 680ffe357..ae86ae622 100644

--- a/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml

+++ b/ppcls/configs/PULC/traffic_sign/SwinTransformer_tiny_patch4_window7_224.yaml

@@ -113,7 +113,7 @@ DataLoader:

dataset:

name: ImageNetDataset

image_root: ./dataset/

- cls_label_path: ./dataset/tt100k_clas_v2/label_list_test.txt

+ cls_label_path: ./dataset/traffic_sign/label_list_test.txt

delimiter: "\t"

transform_ops:

- DecodeImage:

diff --git a/test_tipc/benchmark_train.sh b/test_tipc/benchmark_train.sh

index 793b89476..5c4d4112a 100644

--- a/test_tipc/benchmark_train.sh

+++ b/test_tipc/benchmark_train.sh

@@ -225,7 +225,7 @@ for batch_size in ${batch_size_list[*]}; do

echo $cmd

eval $cmd

last_status=${PIPESTATUS[0]}

- status_check $last_status "${cmd}" "${status_log}"

+ status_check $last_status "${cmd}" "${status_log}" "${model_name}"

else

IFS=";"

unset_env=`unset CUDA_VISIBLE_DEVICES`

@@ -261,7 +261,7 @@ for batch_size in ${batch_size_list[*]}; do

echo $cmd

eval $cmd

last_status=${PIPESTATUS[0]}

- status_check $last_status "${cmd}" "${status_log}"

+ status_check $last_status "${cmd}" "${status_log}" "${model_name}"

fi

done

done

diff --git a/test_tipc/common_func.sh b/test_tipc/common_func.sh

index 63fa10144..e0459366e 100644

--- a/test_tipc/common_func.sh

+++ b/test_tipc/common_func.sh

@@ -38,6 +38,7 @@ function func_set_params(){

function func_parser_params(){

strs=$1

+ MODE=$2

IFS=":"

array=(${strs})

key=${array[0]}

@@ -64,10 +65,10 @@ function status_check(){

last_status=$1 # the exit code

run_command=$2

run_log=$3

+ model_name=$4

if [ $last_status -eq 0 ]; then

- echo -e "\033[33m Run successfully with command - ${run_command}! \033[0m" | tee -a ${run_log}

+ echo -e "\033[33m Run successfully with command - ${model_name} - ${run_command}! \033[0m" | tee -a ${run_log}

else

- echo -e "\033[33m Run failed with command - ${run_command}! \033[0m" | tee -a ${run_log}

+ echo -e "\033[33m Run failed with command - ${model_name} - ${run_command}! \033[0m" | tee -a ${run_log}

fi

}

-

diff --git a/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index b6606beb2..1b970569a 100644

--- a/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PP-ShiTu/PPShiTu_mainbody_det_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -6,7 +6,7 @@ python:python3.7

--model_filename:inference.pdmodel

--params_filename:inference.pdiparams

--save_file:./deploy/models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer/inference.onnx

---opset_version:10

+--opset_version:11

--enable_onnx_checker:True

inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/rec/models/inference/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer.tar

inference:./python/predict_cls.py

diff --git a/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 86e2658ac..0b65824c3 100644

--- a/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPHGNet/PPHGNet_small_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -8,6 +8,7 @@ python:python3.7

--save_file:./deploy/models/PPHGNet_small_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPHGNet_small_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

Global.inference_model_dir:./models/PPHGNet_small_infer

diff --git a/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index c566fcb7e..b31ff8c60 100644

--- a/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPHGNet/PPHGNet_tiny_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -8,6 +8,7 @@ python:python3.7

--save_file:./deploy/models/PPHGNet_tiny_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPHGNet_tiny_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

Global.inference_model_dir:./models/PPHGNet_tiny_infer

diff --git a/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 6a89762ec..62dcb630b 100644

--- a/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPLCNet/PPLCNet_x0_25_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -8,6 +8,7 @@ python:python3.7

--save_file:./deploy/models/PPLCNet_x0_25_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_25_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

Global.inference_model_dir:./models/PPLCNet_x0_25_infer

diff --git a/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 62dcb630b..427d8cc72 100644

--- a/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPLCNet/PPLCNet_x0_35_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -1,16 +1,16 @@

===========================paddle2onnx_params===========================

-model_name:PPLCNet_x0_25

+model_name:PPLCNet_x0_35

python:python3.7

2onnx: paddle2onnx

---model_dir:./deploy/models/PPLCNet_x0_25_infer/

+--model_dir:./deploy/models/PPLCNet_x0_35_infer/

--model_filename:inference.pdmodel

--params_filename:inference.pdiparams

---save_file:./deploy/models/PPLCNet_x0_25_infer/inference.onnx

+--save_file:./deploy/models/PPLCNet_x0_35_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

-inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_25_infer.tar

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_35_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

-Global.inference_model_dir:./models/PPLCNet_x0_25_infer

+Global.inference_model_dir:./models/PPLCNet_x0_35_infer

Global.use_gpu:False

-c:configs/inference_cls.yaml

\ No newline at end of file

diff --git a/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index b6606beb2..c70ef6fc0 100644

--- a/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/PPLCNet/PPLCNet_x0_5_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -1,16 +1,16 @@

===========================paddle2onnx_params===========================

-model_name:PP-ShiTu_mainbody_det

+model_name:PPLCNet_x0_5

python:python3.7

2onnx: paddle2onnx

---model_dir:./deploy/models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer/

+--model_dir:./deploy/models/PPLCNet_x0_5_infer/

--model_filename:inference.pdmodel

--params_filename:inference.pdiparams

---save_file:./deploy/models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer/inference.onnx

+--save_file:./deploy/models/PPLCNet_x0_5_infer/inference.onnx

--opset_version:10

--enable_onnx_checker:True

-inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/rec/models/inference/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer.tar

+inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/PPLCNet_x0_5_infer.tar

inference:./python/predict_cls.py

Global.use_onnx:True

-Global.inference_model_dir:./models/picodet_PPLCNet_x2_5_mainbody_lite_v1.0_infer

+Global.inference_model_dir:./models/PPLCNet_x0_5_infer

Global.use_gpu:False

-c:configs/inference_cls.yaml

\ No newline at end of file

diff --git a/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt b/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

index 64ca64494..82806311e 100644

--- a/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

+++ b/test_tipc/config/ResNet/ResNet50_vd_linux_gpu_normal_normal_paddle2onnx_python_linux_cpu.txt

@@ -9,8 +9,8 @@ python:python3.7

--opset_version:10

--enable_onnx_checker:True

inference_model_url:https://paddle-imagenet-models-name.bj.bcebos.com/dygraph/inference/ResNet50_vd_infer.tar

-inference: python/predict_cls.py -c configs/inference_cls.yaml

+inference:./python/predict_cls.py

Global.use_onnx:True

-Global.inference_model_dir:models/ResNet50_vd_infer/

+Global.inference_model_dir:./models/ResNet50_vd_infer/

Global.use_gpu:False

-c:configs/inference_cls.yaml

diff --git a/test_tipc/prepare.sh b/test_tipc/prepare.sh

index 7951412fb..ca7b6a5b6 100644

--- a/test_tipc/prepare.sh

+++ b/test_tipc/prepare.sh

@@ -240,7 +240,7 @@ if [[ ${MODE} = "paddle2onnx_infer" ]]; then

inference_model_url=$(func_parser_value "${lines[10]}")

tar_name=${inference_model_url##*/}

- ${python_name} -m pip install install paddle2onnx

+ ${python_name} -m pip install paddle2onnx

${python_name} -m pip install onnxruntime

cd deploy

mkdir models

diff --git a/test_tipc/test_inference_cpp.sh b/test_tipc/test_inference_cpp.sh

index 0821751c2..abba66503 100644

--- a/test_tipc/test_inference_cpp.sh

+++ b/test_tipc/test_inference_cpp.sh

@@ -63,7 +63,7 @@ function func_shitu_cpp_inference(){

command="${_script} > ${_save_log_path} 2>&1"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

done

done

done

@@ -87,7 +87,7 @@ function func_shitu_cpp_inference(){

command="${_script} > ${_save_log_path} 2>&1"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

done

done

done

@@ -125,7 +125,7 @@ function func_cls_cpp_inference(){

command1="${_script} > ${_save_log_path} 2>&1"

eval ${command1}

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command1}" "${status_log}"

+ status_check $last_status "${command1}" "${status_log}" "${model_name}"

done

done

done

@@ -148,7 +148,7 @@ function func_cls_cpp_inference(){

command="${_script} > ${_save_log_path} 2>&1"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

done

done

done

diff --git a/test_tipc/test_inference_jeston.sh b/test_tipc/test_inference_jeston.sh

index 2fd76e1e9..568450039 100644

--- a/test_tipc/test_inference_jeston.sh

+++ b/test_tipc/test_inference_jeston.sh

@@ -71,7 +71,7 @@ if [ ${MODE} = "whole_infer" ]; then

echo $export_cmd

eval $export_cmd

status_export=$?

- status_check $status_export "${export_cmd}" "${status_log}"

+ status_check $status_export "${export_cmd}" "${status_log}" "${model_name}"

else

save_infer_dir=${infer_model}

fi

diff --git a/test_tipc/test_lite_arm_cpu_cpp.sh b/test_tipc/test_lite_arm_cpu_cpp.sh

index 86c340060..919226eea 100644

--- a/test_tipc/test_lite_arm_cpu_cpp.sh

+++ b/test_tipc/test_lite_arm_cpu_cpp.sh

@@ -67,7 +67,7 @@ function func_test_tipc(){

eval ${command1}

command2="adb shell 'export LD_LIBRARY_PATH=${lite_arm_work_path}; ${real_inference_cmd}' > ${_save_log_path} 2>&1"

eval ${command2}

- status_check $? "${command2}" "${status_log}"

+ status_check $? "${command2}" "${status_log}" "${model_name}"

done

done

done

diff --git a/test_tipc/test_paddle2onnx.sh b/test_tipc/test_paddle2onnx.sh

index fd2f1d90e..c869f8f3b 100644

--- a/test_tipc/test_paddle2onnx.sh

+++ b/test_tipc/test_paddle2onnx.sh

@@ -3,13 +3,6 @@ source test_tipc/common_func.sh

FILENAME=$1

-dataline=$(cat ${FILENAME})

-lines=(${dataline})

-# common params

-model_name=$(func_parser_value "${lines[1]}")

-python=$(func_parser_value "${lines[2]}")

-

-

# parser params

dataline=$(awk 'NR==1, NR==16{print}' $FILENAME)

IFS=$'\n'

@@ -43,7 +36,7 @@ inference_config_key=$(func_parser_key "${lines[15]}")

inference_config_value=$(func_parser_value "${lines[15]}")

LOG_PATH="./test_tipc/output/${model_name}"

-mkdir -p ./test_tipc/output

+mkdir -p ${LOG_PATH}

status_log="${LOG_PATH}/results_paddle2onnx.log"

@@ -62,7 +55,8 @@ function func_paddle2onnx(){

trans_model_cmd="${padlle2onnx_cmd} ${set_dirname} ${set_model_filename} ${set_params_filename} ${set_save_model} ${set_opset_version} ${set_enable_onnx_checker}"

eval $trans_model_cmd

last_status=${PIPESTATUS[0]}

- status_check $last_status "${trans_model_cmd}" "${status_log}"

+ status_check $last_status "${trans_model_cmd}" "${status_log}" "${model_name}"

+

# python inference

set_model_dir=$(func_set_params "${inference_model_dir_key}" "${inference_model_dir_value}")

set_use_onnx=$(func_set_params "${use_onnx_key}" "${use_onnx_value}")

@@ -70,7 +64,7 @@ function func_paddle2onnx(){

set_inference_config=$(func_set_params "${inference_config_key}" "${inference_config_value}")

infer_model_cmd="cd deploy && ${python} ${inference_py} -o ${set_model_dir} -o ${set_use_onnx} -o ${set_hardware} ${set_inference_config} > ${_save_log_path} 2>&1 && cd ../"

eval $infer_model_cmd

- status_check $last_status "${infer_model_cmd}" "${status_log}"

+ status_check $last_status "${infer_model_cmd}" "${status_log}" "${model_name}"

}

diff --git a/test_tipc/test_train_inference_python.sh b/test_tipc/test_train_inference_python.sh

index 2f2b3b65a..427005cf0 100644

--- a/test_tipc/test_train_inference_python.sh

+++ b/test_tipc/test_train_inference_python.sh

@@ -126,7 +126,7 @@ function func_inference(){

eval $command

last_status=${PIPESTATUS[0]}

eval "cat ${_save_log_path}"

- status_check $last_status "${command}" "../${status_log}"

+ status_check $last_status "${command}" "../${status_log}" "${model_name}"

done

done

done

@@ -151,7 +151,7 @@ function func_inference(){

eval $command

last_status=${PIPESTATUS[0]}

eval "cat ${_save_log_path}"

- status_check $last_status "${command}" "../${status_log}"

+ status_check $last_status "${command}" "../${status_log}" "${model_name}"

done

done

done

@@ -198,7 +198,7 @@ elif [[ ${MODE} = "klquant_whole_infer" ]]; then

command="${python} ${kl_quant_cmd_value}"

eval $command

last_status=${PIPESTATUS[0]}

- status_check $last_status "${command}" "${status_log}"

+ status_check $last_status "${command}" "${status_log}" "${model_name}"

cd inference/quant_post_static_model

ln -s __model__ inference.pdmodel

ln -s __params__ inference.pdiparams

@@ -301,7 +301,7 @@ else

# export FLAGS_cudnn_deterministic=True

sleep 5

eval $cmd

- status_check $? "${cmd}" "${status_log}"

+ status_check $? "${cmd}" "${status_log}" "${model_name}"

sleep 5

if [[ $FILENAME == *GeneralRecognition* ]]; then

@@ -318,7 +318,7 @@ else

set_eval_params1=$(func_set_params "${eval_key1}" "${eval_value1}")

eval_cmd="${python} ${eval_py} ${set_eval_pretrain} ${set_use_gpu} ${set_eval_params1}"

eval $eval_cmd

- status_check $? "${eval_cmd}" "${status_log}"

+ status_check $? "${eval_cmd}" "${status_log}" "${model_name}"

sleep 5

fi

# run export model

@@ -333,7 +333,7 @@ else

set_save_infer_key=$(func_set_params "${save_infer_key}" "${save_infer_path}")

export_cmd="${python} ${run_export} ${set_export_weight} ${set_save_infer_key}"

eval $export_cmd

- status_check $? "${export_cmd}" "${status_log}"

+ status_check $? "${export_cmd}" "${status_log}" "${model_name}"

#run inference

eval $env